I de seneste måneder har jeg set en stigning i AI-genererede videoer, hvor kendte personer “optræder” i reklamer for investeringsmuligheder, kryptoplatforme eller andre finansielle “mirakelprodukter”. Problemet? Personerne har aldrig sagt eller godkendt det, du ser.

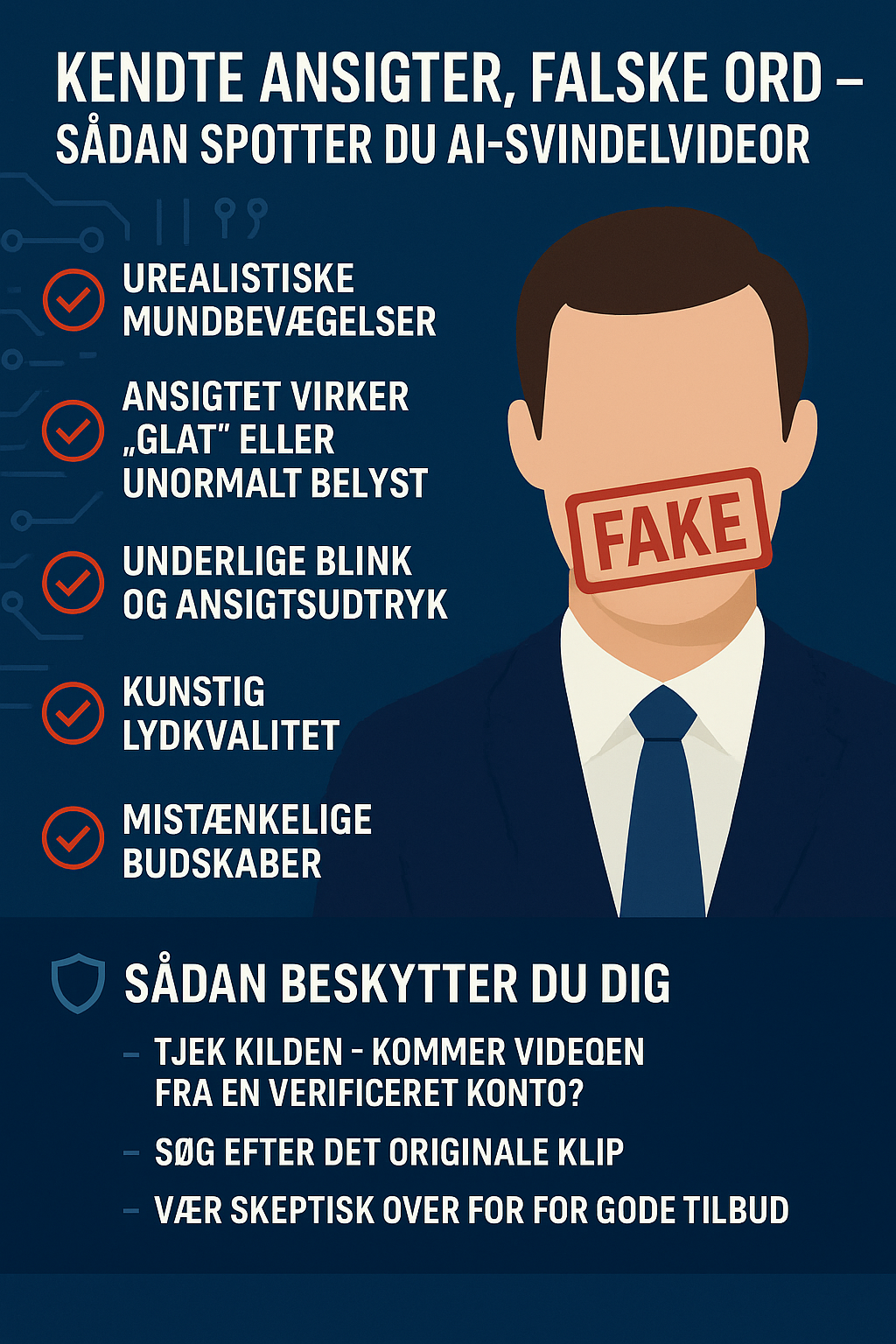

🔍 Hvordan ser man forskel?

AI-videoer bliver bedre og bedre, men de efterlader ofte små tegn:

1. Urealistisk mundbevægelser

Synkroniseringen mellem lyd og mund kan være en anelse forsinket eller unaturlig. Mundens form passer ikke altid perfekt til ordene.

2. Ansigtet virker “glat” eller unormalt belyst

AI-tuning kan give huden et næsten voksagtigt udseende eller kunstige lysreflekser, især i bevægelse.

3. Underlige blink og ansigtsudtryk

Blink kan være sjældent, unaturligt hurtigt eller forekomme i underlige øjeblikke.

4. Kunstig lydkvalitet

Stemmen kan lyde flad, for “ren” eller robotagtig – især hvis der mangler naturlig vejrtrækning, små pauser eller variation i tonefald.

5. Mistænkelige budskaber

Kendte personer opfordrer sjældent til hurtige investeringer, specielt ikke med løfter om garanteret profit.

Eksempler på falske AI-videoer

Nedenfor har jeg indsat tre eksempler på AI-genererede videoer, hvor kendte personer bliver misbrugt i reklamer for finansielle tilbud.

Formålet er udelukkende at vise, hvordan manipuleret indhold kan se ud – ikke at fremme eller støtte budskaberne i videoerne.

Som du vil se, er der flere tegn på, at de ikke er ægte:

- Lyd og mundbevægelser passer ikke helt sammen.

- Ansigtsudtryk virker stive eller unaturlige.

- Stemmen mangler naturlige pauser og variation.

- Baggrund og belysning kan se “forkert” ud i forhold til personens normale optrædener.

- Sproget er ikke dansk som vi normalt hører i Nyhederne og på TV

🛡️ Sådan beskytter du dig

- Tjek kilden – Kommer videoen fra en verificeret konto?

- Søg efter det originale klip – Brug Google Lens eller billedsøgning på et stillbillede.

- Vær skeptisk over for for gode tilbud – Hvis det lyder for godt til at være sandt, er det sandsynligvis falsk.

- Rapportér indholdet – Hjælper med at begrænse spredningen.

Kendte ansigter kan efterlignes af AI, men dit sunde skeptiske blik kan ikke kopieres. Stol på mavefornemmelsen, og vær ekstra ekstra kritisk, når det handler om penge.

Ny aftale skal beskytte dig mod deepfakes af din krop og stemme

Regeringen (Socialdemokratiet, Venstre og Moderaterne), Danmarksdemokraterne, Socialistisk Folkeparti, Det Konservative Folkeparti, Enhedslisten, Radikale Venstre og Alternativet er enige om en aftale vedr. et værn mod digitale efterligninger indeholdende personlige kendetegn.

Skriv et svar

Du skal være logget ind for at skrive en kommentar.